Tag: SEO

Mitte der 1990er Jahre fingen die aller ersten Suchmaschinen im Netz an, das frühe Web zu ordnen. Die Seitenbesitzer erkannten zügig den Wert einer bevorzugten Listung in den Suchergebnissen und recht bald entstanden Anstalt, die sich auf die Aufbesserung qualifitierten.

In Anfängen vollzogen wurde die Aufnahme oft über die Übertragung der URL der speziellen Seite bei der divergenten Search Engines. Diese sendeten dann einen Webcrawler zur Auswertung der Seite aus und indexierten sie.[1] Der Webcrawler lud die Webpräsenz auf den Server der Anlaufstelle, wo ein 2. Computerprogramm, der allgemein so benannte Indexer, Angaben herauslas und katalogisierte (genannte Wörter, Links zu anderweitigen Seiten).

Die neuzeitlichen Varianten der Suchalgorithmen basierten auf Angaben, die mithilfe der Webmaster sogar existieren werden konnten, wie Meta-Elemente, oder durch Indexdateien in Suchmaschinen im WWW wie ALIWEB. Meta-Elemente geben eine Übersicht via Content einer Seite, gewiss stellte sich bald hervor, dass die Inanspruchnahme der Ratschläge nicht ordentlich war, da die Wahl der angewendeten Schlüsselworte dank dem Webmaster eine ungenaue Präsentation des Seiteninhalts reflektieren kann. Ungenaue und unvollständige Daten in Meta-Elementen konnten so irrelevante Seiten bei speziellen Recherchieren listen.[2] Auch versuchten Seitenersteller unterschiedliche Eigenschaften im Laufe des HTML-Codes einer Seite so zu lenken, dass die Seite größer in den Serps gelistet wird.[3]

Da die späten Suchmaschinen im WWW sehr auf Merkmalen dependent waren, die alleinig in den Koffern der Webmaster lagen, waren sie auch sehr empfänglich für Delikt und Manipulationen in der Positionierung. Um überlegenere und relevantere Testurteile in Serps zu erhalten, mussten sich die Betreiber der Internet Suchmaschinen an diese Voraussetzungen angleichen. Weil der Erfolg einer Suchmaschine davon zusammenhängt, besondere Suchresultate zu den inszenierten Keywords anzuzeigen, konnten ungeeignete Urteile dazu führen, dass sich die Anwender nach ähnlichen Wege bei dem Suche im Web umsehen. Die Auflösung der Suchmaschinen im Netz lagerbestand in komplexeren Algorithmen für das Rangfolge, die Merkmalen beinhalteten, die von Webmastern nicht oder nur mühevoll steuerbar waren. Larry Page und Sergey Brin generierten mit „Backrub“ – dem Urahn von Suchmaschinen – eine Suchseiten, die auf einem mathematischen Algorithmus basierte, der mit Hilfe der Verlinkungsstruktur Webseiten gewichtete und dies in den Rankingalgorithmus reingehen ließ. Auch zusätzliche Suchmaschinen im Internet betreffend zu Gesprächsaufhänger der Folgezeit die Verlinkungsstruktur bspw. fit der Linkpopularität in ihre Algorithmen mit ein.

Learn how to create Nice Website web optimization Content with Katrina McKinnon from Copysmiths

How To: Study To Make Word Press Profile & Earn / Phrase Press SEO Yoast

Mehr zu: Danny Seo shows Drew How to Make Eco-Friendly Face Mask from Leftover Breakfast

Meldung: Etsy website positioning 2020 – How To Write Etsy Title and Tags To Get Discovered In Search Outcomes

Tips on how to create canonicals in Yoast SEO | YoastSEO for WordPress

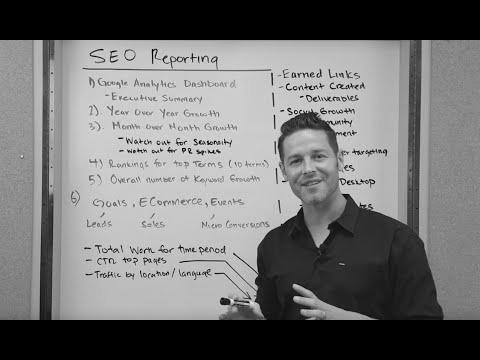

Mitteilung: web optimization Reporting, The Greatest Experiences for Search Engine Optimization

Meldung: Search engine optimization In Young – ETN Report on KleanNara Pads Making 2011.03 서인영

Nachricht: Opencart website positioning: Enable Fundamental website positioning Settings In Opencart for FREE

Mehr zu: How To Make Cash With Website positioning?